如何为人工智能系统和GPU提供动力

很明显,人工智能如何通过神经网络进行,而不是80年代和90年代的旧学校系统。很明显,硬件正在开始发展,而且很明显我们为这些硬件系统供电的方式将不得不改变。

GPU和人工智能硬件的功耗非常大,本周我们与Vicor公司的Robert Gendron进行了对话,后者是一家专注于为AI系统供电的公司。Vicor与Kisaco Research合作,该公司将于9月17日和18日在加利福尼亚州山景城举办2019年AI硬件峰会。

罗伯特谈到为什么他们的动力方式需要与传统的制造设备不同。他还讨论了如果企业希望降低能源成本并且在人工智能方面尽可能高效,那么这些系统的供电需要如何运作。

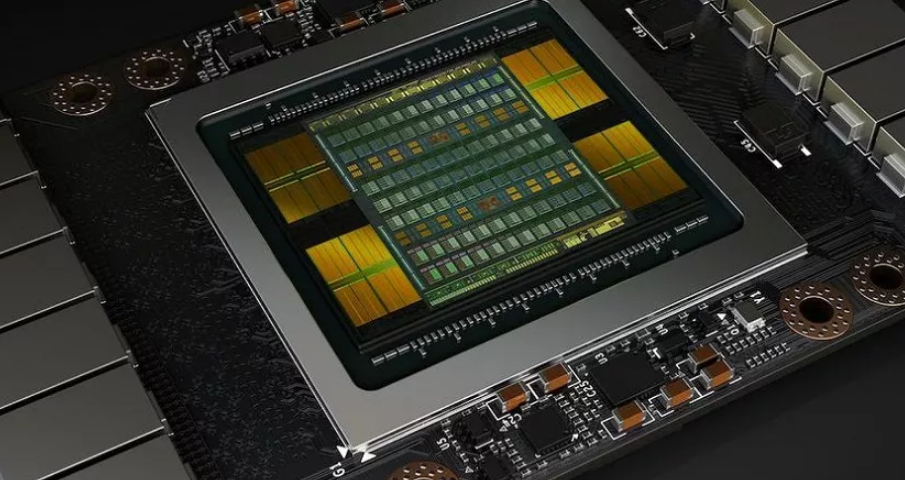

Robert Gendron:我们已经看到人工智能应用中使用的GPU和ASIC,其功率需求已经从几百瓦增加到现在我们正在与一些客户一起工作到千瓦范围。更重要的是功率水平本身就是如何提供动力。也就是说,它通常低于一伏特,并且与计划相比低于一伏,这意味着它大约有一千安培的电流。因此在非常低的电压下具有非常高的电流。

最好考虑一个灯泡。典型的灯泡是60瓦。再说一遍,我们谈的是一个处理器消耗的千瓦。再说一个处理器就是一个服务器机架,然后是服务器场。因此,我们通常通过AI型处理器来讨论大量功耗。

具有讽刺意味的是,该行业通常使用的解决方案已经存在了大约20年。它被称为多阶段电源方案。您可以想象它是一个并联的电压调节器或电源块,或者通过将更多这些电源块组合在一起来扩展,以创建越来越大的整体电源传输系统。

(04:15)所以这就是在这些巨大的服务器中心之一用于你的Facebook世界,你的谷歌世界?

RG:是的,确切地说。我的意思是你有可能在你面前的笔记本电脑,与我的相同。你有这种多相方案,你的处理器正在供电,比如三个或四个这些小功率块一起缩放。但对于GPU,您可以将多达20个这些电源块并联在一起供电。